AFT : Tecnologia para Formatação Avançada - Conceitos básicos

Este artigo tem como objetivo, divulgar a tecnologia AFT para formatação de discos com blocos físicos de 4 KiB.

[ Hits: 12.641 ]

Por: Perfil removido em 03/04/2013

Arquitetura legada de discos rígidos

Cenário

Nos primórdios da computação, o tamanho de um setor físico em um disco rígido foi definido em 512 bytes. A unidade de alocação (cluster) é o conjunto de setores físicos que formam uma unidade lógica.No disco de 10 MiB do IBM-PC XT, a relação entre setores físicos e lógicos foi definida em 1-1, ou seja, uma unidade lógica para cada unidade física.

Em sistemas modernos, essa relação foi sendo modificada de forma lógica para 1-2, 1-4 até 1-8 (1 KiB, 2 KiB ou 4 KiB). Ainda assim, o tamanho do setor físico foi mantido em 512 bytes independente do tamanho do disco rígido.

Com o aumento da capacidade de armazenamento dos discos rígidos, os setores de 512 bytes começaram a se tornar um problema. Vamos entender esse cenário.

Há 30 anos, o tamanho médio dos arquivos situava-se entre 512 e 2048 bytes e sua quantidade era medida aos milhares. Fazia sentido ter setores físicos e lógicos com 512 bytes. Atualmente, a quantidade de arquivos no disco rígido é medida em centenas de milhares e o tamanho médio desses arquivos se situa entre 4096 e 16384 bytes.

O tamanho dos arquivos não é o problema, pois a capacidade e a velocidade dos discos também acompanhou esse crescimento. A questão central é a quantidade de metadados necessários para manter a integridade dos pequenos pedaços de dados gravados no disco.

A existência dos metadados escapa a maioria dos usuários, o que é bem normal, já que esse assunto é pura escovação de bit. Metadados são dados sobre os dados. São estruturas de dados que possibilitam a localização e recuperação dos dados gravados no disco.

Observe que uma parte da capacidade de um disco rígido é ocupada pelos metadados, então, se há muitos metadados sobra menos espaço para dados. Resumindo, metadados são bons até certo ponto, depois começam a incomodar.

Arquitetura legada de discos rígidos

Desde do início, a abordagem para criar discos rígidos cada vez maiores foi apoiada em três fatores que são constantemente balanceados entre si:- A densidade da área de dados;

- A relação sinal-ruído (SNR - Signal-To-Noise Ratio);

- Métodos de Correção de Erros (ECC - Error Correcting Code).

A relação entre esses parâmetros é inversamente proporcional. Por exemplo, quando os fabricantes inventam uma nova técnica para inserir mais setores no mesmo espaço físico (aumento da densidade), a relação sinal-ruído tende a aumentar provocando mais erros de leitura/gravação do que antes.

A relação sinal-ruído é a medida da relação entre o tempo de busca (seek) e o nível de ruído (noise). O nível de ruído é perceptível para humanos como vibrações e solavancos, pois as cabeças do disco serão aceleradas e freadas bruscamente, em curto espaço de tempo, para se posicionarem rapidamente sobre a área desejada.

O motor do HD será responsável por parte do nível de ruído junto com as partes mecânicas que geram vibrações, solavancos, calor e até ruídos sonoros (todos são formas de energia: mecânica, térmica e sonora). Se o nível de ruídos aumentar, a quantidade de erros de leitura/gravação tende a aumentar também, e quase sempre em proporção maior. Assim, abrimos mão de velocidade em favor de mais estabilidade.

Se desejamos tempos de busca menores, então, podemos compensar parte do desequilíbrio geral do sistema com métodos de correção de erros (ECC) que, a grosso modo, podemos dizer que se baseiam na abordagem do tipo que usamos para "lavar os cabelos".

Segundo [1], a instrução no shampoo diz: "passar, enxaguar e repetir até alcançar o resultado desejado". Em outras palavras: "gravar, checar e se necessário regravar até alcançar o resultado desejado".

Para o usuário doméstico isso é transparente e o impacto é relativamente baixo. Todavia, o custo computacional dessa técnica é cada vez maior em ambiente de produção. A velocidade final dos discos está se tornando um gargalo em ambientes onde a quantidade de leituras e gravações simultâneas é muito grande.

O aumento do tamanho das unidades de discos rígidos se apoiou nesse método até esbarrar nas limitações da própria técnica. Os fabricantes estão inserindo cada vez mais redundância de ECC para obter ganhos cada vez menores. Atualmente há 40 bits de ECC e a previsão é chegar ao dobro disso.

Outra questão é que os fabricantes de discos são avaliados pelo mercado por sua capacidade de inovação (novos modelos com maior capacidade) e sua qualidade técnica. Observe que, na prática, inserir mais metadados acaba por reduzir o espaço para os dados. Inserir mais ECC aumenta o tempo de latência. Isso leva a uma situação onde são dados dois passos para frente e um e meio para trás.

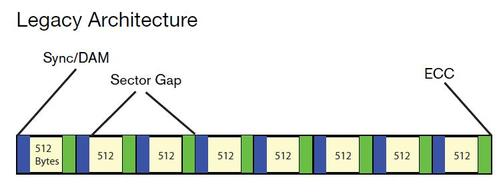

O custo computacional para calcular milhões de validações ECC para milhares de processos de leitura/gravação a cada segundo, pode impactar a capacidade de processamento do disco. Em setores de 512 bytes, a quantidade de lacunas (gaps) entre setores é outro fator de redução de desempenho e de espaço útil para dados.

De acordo com [1], um setor de 4 K gera, em média, 100 bytes de metadados ECC, enquanto a mesma quantidade de dados (4 K) alocada em setores de 512 bytes necessita de 320 bytes de metadados.

As perdas de espaço e desempenho se situam na faixa de 7% a 11%, o que é muito, se comparado com a grande capacidade dos discos rígidos mais modernos. A figura 1 ilustra a relação entre o espaço para dados, para metadados e as lacunas (gaps) em um disco legado com o tradicional relação de 1-1 (lógico/físico):

2. O padrão ATA-8

Pebrot, MSN messenger no terminal

PLC no Linux alguém já pensou nisso?

Os navegadores "leves" que de leves não tem nada

Formatando o bash com cores e efeitos

Usando aMSN com plugin Music com suporte ao Juk e Amarok

O mundo a um clique e um "Eu" fora de nós

O Software Livre precisa de você!

Cultura Hacker - Tenha ética e ganharás respeito

Particionamento GPT - Conceitos básicos

Como tornar-se um membro da comunidade Linux

Muito bom e muito esclarecedor seu artigo. Parabéns. Já vai pros favoritos.

Parabens !!!! KYETOY

Muito bom seu Artigo, leitura boa e conteúdo bom !!!

Abraço

Patrocínio

Destaques

Artigos

Instalação Completa e Configuração Básica do Void Linux

A Fundação da Confiança Digital: A Importância Estratégica de uma PKI CA na Segurança de Dados

Como enviar dicas ou artigos para o Viva o Linux

Como Ativar a Aceleração por GPU (ROCm) no Ollama para AMD Navi 10 (RX 5700 XT / 5600) no Gentoo

Dicas

Samba 4 AD-DC 2026: Backup & Restore

Samba 4 AD-DC 2026: LAPS (Randomizando senhas locais).

Cairo Dock ainda funcional nos dias de hoje

Configuração de IP fixo via nmcli e resolução de nomes via /etc/hosts no Gentoo

Tópicos

Top 10 do mês

-

Xerxes

1° lugar - 127.704 pts -

Fábio Berbert de Paula

2° lugar - 54.750 pts -

Buckminster

3° lugar - 33.680 pts -

Sidnei Serra

4° lugar - 20.390 pts -

Alberto Federman Neto.

5° lugar - 19.908 pts -

Mauricio Ferrari (LinuxProativo)

6° lugar - 18.522 pts -

Daniel Lara Souza

7° lugar - 18.169 pts -

Alessandro de Oliveira Faria (A.K.A. CABELO)

8° lugar - 17.549 pts -

edps

9° lugar - 16.427 pts -

Andre (pinduvoz)

10° lugar - 14.232 pts